Chez Smartpoint, nous assistons à une nouvelle révolution industrielle axée sur la génération d’intelligence grâce à l’IA … et cette révolution nécessite des infrastructures adaptées aux nouvelles exigences des entreprises, notamment en matière de gestion de volumes massifs et diversifiés de données. Nous pensons que le prochain axe majeur d’investissement sera la couche d’infrastructure de données, indispensable pour donner vie à des applications d’IA personnalisées.

L’infrastructure de données : fondation de la révolution IA

Les infrastructures de données doivent évoluer pour gérer des données non structurées à grande échelle, telles que les vidéos, images, audios, et même les données spatiales ! Avec l’essor de l’IA générative (GenAI), la qualité des données devient primordiale, non seulement pour l’entraînement des modèles, mais aussi pour leur inférence. La capacité à acquérir, nettoyer, transformer et organiser ces données est désormais un facteur clé de réussite.

D’ailleurs, le marché mondial des infrastructures IA connaît une croissance fulgurante. Il est estimé à 68,46 milliards de dollars en 2024 et pourrait atteindre 171,21 milliards de dollars d’ici 2029, avec un taux de croissance annuel moyen (CAGR) de 20,12 %. Cette progression est alimentée par l’adoption rapide de l’IA dans des secteurs variés, allant des grandes entreprises aux startups.

Automatisation et pipelines de données optimisés par l’IA

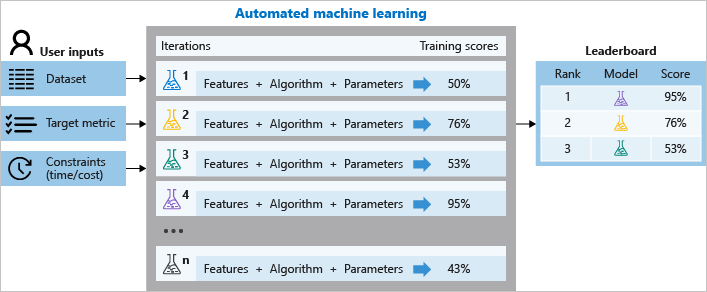

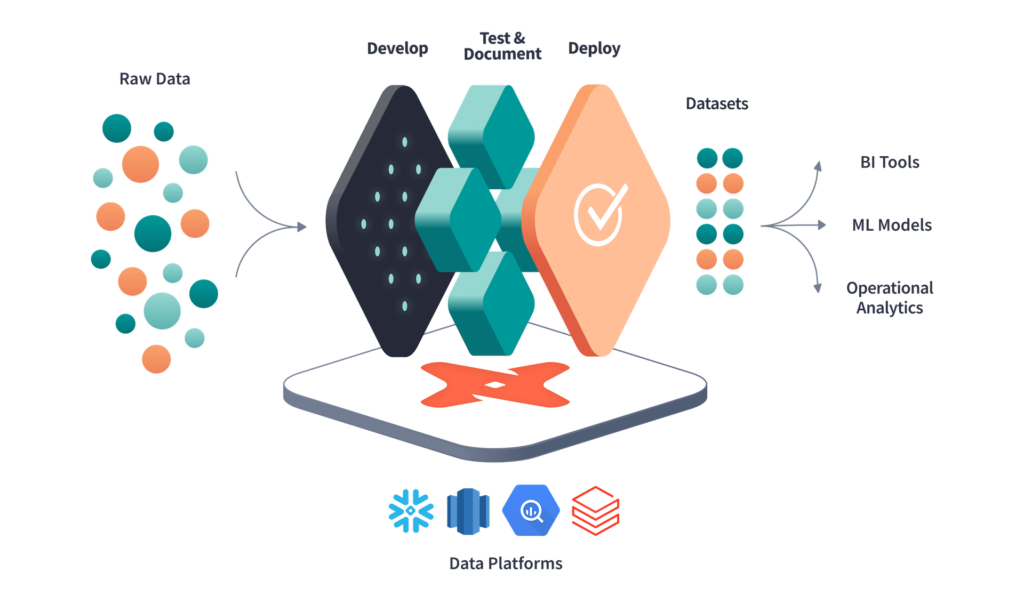

L’une des principales avancées concerne l’automatisation des pipelines de données. Grâce à l’IA, des workflows end-to-end peuvent être mis en place pour gérer le traitement des données non structurées, de leur extraction à leur stockage en passant par leur transformation. Cela inclut des technologies comme le chunking (fractionnement des données en petites portions), l’indexation et la génération d’embeddings (représentations vectorielles) qui permettent une recherche plus rapide et pertinente. Cette approche devient indispensable dans des applications d’IA conversationnelle et d’agents autonomes.

Impact de l’inférence IA et essor de l’edge computing

L‘inférence IA, qui consiste à utiliser des modèles pour prendre des décisions en temps réel, est en pleine essor. Cet engouement est notamment soutenu par le edge computing, qui rapproche le traitement des données de leur source pour réduire les latences et optimiser les performances, tout en minimisant les coûts liés à la transmission des données vers le cloud. Cette technologie devient primordiale dans des secteurs tels que l’industrie manufacturière et évidemment la santé.

La récupération augmentée (RAG) : maximiser l’efficacité des applications IA

Une des innovations majeures observées dans les infrastructures de données est la génération augmentée par récupération (RAG). Cette méthode permet aux entreprises d’activer leurs données pour fournir des réponses plus précises et à jour via des modèles de langage (LLM). En combinant les données internes avec des requêtes, le RAG permet d’améliorer considérablement la fiabilité et la personnalisation des réponses générées par l’IA. Cela constitue un avantage concurrentiel pour les entreprises qui cherchent à fournir des expériences utilisateurs plus précises et crédibles.

Une gestion éthique et durable des données

Chez Smartpoint, nous croyons fermement à l’importance d’une gestion responsable et éthique des infrastructures de données. Nous nous engageons à éviter le Data Swamp, où des données non pertinentes s’accumulent, en nous concentrant sur la collecte et l’exploitation des données à forte valeur ajoutée. Cette approche permet non seulement d’améliorer la performance opérationnelle, mais aussi de respecter les régulations en matière de confidentialité, telles que le RGPD, tout en adoptant une démarche durable pour un usage plus responsable des ressources informatiques.

… Une infrastructure résiliente pour un avenir axé sur l’IA

Les infrastructures de données sont en pleine transformation sous l’impulsion de l’IA. Chez Smartpoint, pure player data depuis 2006, nous aidons nos clients à adapter leur architecture aux besoins croissants de l’IA, tout en assurant une gestion responsable et éthique des données. Ces évolutions permettront non seulement d’améliorer les performances des modèles IA, mais aussi d’offrir aux entreprises les moyens de se démarquer dans un marché toujours plus compétitif.

LAISSEZ-NOUS UN MESSAGE

Les champs obligatoires sont indiqués avec *.