La donnée est le moteur des entreprises. Disposer d’une architecture data moderne permet de l’exploiter. La volumétrie exponentielle, la nécessité d’analyses en temps réel et le développement de l’IA obligent les organisations à repenser en profondeur leurs plateformes de données.

Entre data warehouse, data lake et désormais data lakehouse, les entreprises doivent choisir des architectures capables d’offrir scalabilité, gouvernance des données et évolutivité. C’est ce socle technologique qui conditionne la performance décisionnelle et l’innovation métier. Mode d’emploi avec nos experts en architecture Data.

Pourquoi moderniser sa plateforme data ?

Une plateforme data moderne n’est plus seulement un entrepôt passif de données. Alors que les entreprises sont amenées à manipuler des volumes massifs et hétérogènes de données, la plateforme data est devenu un socle stratégique.

Sa mission : garantir la qualité et la gouvernance des données, tout en assurant une évolutivité et une scalabilité data native capables de suivre la croissance des usages.

L’enjeu ne se limite pas à stocker : il s’agit d’offrir des capacités temps réel, d’intégrer l’IA et le machine learning au cœur des workflows, et de connecter la donnée aux décisions métier de manière fluide.

En modernisant leur architecture data, les organisations sortent de la logique de silos pour bâtir une plateforme unifiée et agile, où cohabitent data lake, data warehouse et data lakehouse. Cette convergence crée un environnement solide prêt à absorber les évolutions business et à soutenir une exploitation réellement data-driven.

Data Warehouse : l’entrepôt de données historique

Le data warehouse (ou entrepôt de données) est le socle historique de la BI.

- Structuré, gouverné et performant pour les analyses décisionnelles.

- Optimisé pour les données relationnelles et les KPIs métiers.

- Limites : faible flexibilité face aux données non structurées et aux usages temps réel.

Aujourd’hui, le data warehouse est toujours incontournable pour les reporting consolidés et la gouvernance stricte des données.

Data Lake : la flexibilité et le stockage brut

Le data lake (ou datalake) a bouleversé les architectures en permettant :

- le stockage massif de données brutes, structurées et non structurées,

- l’intégration de nouvelles sources (IoT, logs, réseaux sociaux),

- une scalabilité data quasi illimitée grâce au cloud.

Il s’est imposé comme le socle idéal pour l’IA et le machine learning. Mais sans gouvernance, le data lake peut rapidement devenir un “data swamp”…

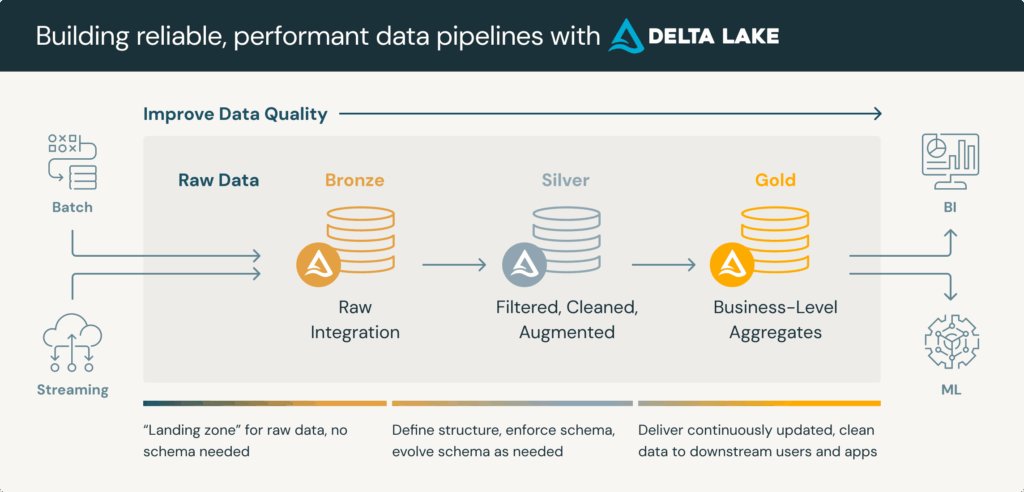

Lakehouse : la convergence des mondes BI et Big Data

Le data lakehouse s’impose aujourd’hui comme l’évolution naturelle des architectures data modernes. En combinant la flexibilité et la scalabilité d’un data lake avec la rigueur et la gouvernance d’un data warehouse, il offre une plateforme unifiée capable de répondre aux besoins des entreprises data-driven. Concrètement, un lakehouse permet de réaliser des analyses temps réel tout en garantissant la qualité et la gouvernance des données, un enjeu majeur pour les organisations confrontées à des volumes massifs et hétérogènes.

Autre avantage de taille ? Sa compatibilité native avec les outils de BI modernes comme Power BI, Tableau ou Qlik, qui peuvent interroger directement les données sans perte de performance. Le modèle lakehouse ouvre également la voie à des usages avancés en intelligence artificielle et machine learning en intégrant nativement les besoins de l’analytique augmentée.

Des acteurs technologiques majeurs comme Snowflake, Databricks, Delta Lake ou Microsoft Fabric sont les fers de lance de cette convergence, offrant aux entreprises une architecture data moderne qui allie performance, évolutivité et agilité. Il n’y a plus aucun nouveau projet chez Smartpoint sans eux !

LakeData : la cible pour une architecture data moderne

Chez Smartpoint, nous privilégions l’approche LakeData comme la réponseaux défis des architectures data modernes. Cette approche repose sur un socle hybride qui combine la flexibilité d’un data lake avec la robustesse et la structuration d’un data warehouse. Pour nous, cela permet de mettre à disposition des entreprises une plateforme décisionnelle moderne, capable de concilier agilité et gouvernance.

Là où un simple entrepôt de données peine à absorber la diversité des formats, LakeData apporte une gouvernance BI intégrée, garantissant la qualité des données, la conformité réglementaire (RGPD) et une sécurité by design. Sa scalabilité native permet d’accompagner la croissance des volumes et des usages data sans rupture de performance.

Pensée pour l’interopérabilité, LakeData s’intègre naturellement avec les grandes plateformes cloud (Azure, AWS, GCP) et les principaux outils de BI du marché tels que Power BI, Tableau, Qlik ou SAP Analytics Cloud.

En s’appuyant sur LakeData, les entreprises peuvent s’appuyer sur une architecture data moderne, évolutive et IA-ready, capable de soutenir aussi bien les besoins analytiques quotidiens que les usages avancés en machine learning et en analytique augmentée.

Quel est l’intérêt de moderniser votre architecture data ?

- Agilité métier : intégration rapide de nouvelles sources et nouveaux cas d’usage.

- Décisionnel temps réel : KPIs mis à jour en continu.

- Réduction des coûts : rationalisation des plateformes et migration cloud.

- Adoption renforcée : BI agile et self-service BI sécurisé.

- Évolutivité data : architecture prête pour l’IA, le machine learning et la croissance future.

Quelles tendances pour 2026 ?

L’architecture data moderne ne cesse d’évoluer, portée par des dynamiques technologiques qui redéfinissent les usages et les standards. À l’horizon 2026, plusieurs tendances structurantes s’imposent déjà comme des incontournables.

Le cloud natif devient la norme et le multicloud une stratégie adoptée par les entreprises qui cherchent à éviter les dépendances et à tirer parti des forces de chaque fournisseur. Cette orientation renforce la flexibilité et ouvre la voie à des plateformes data interopérables et résilientes.

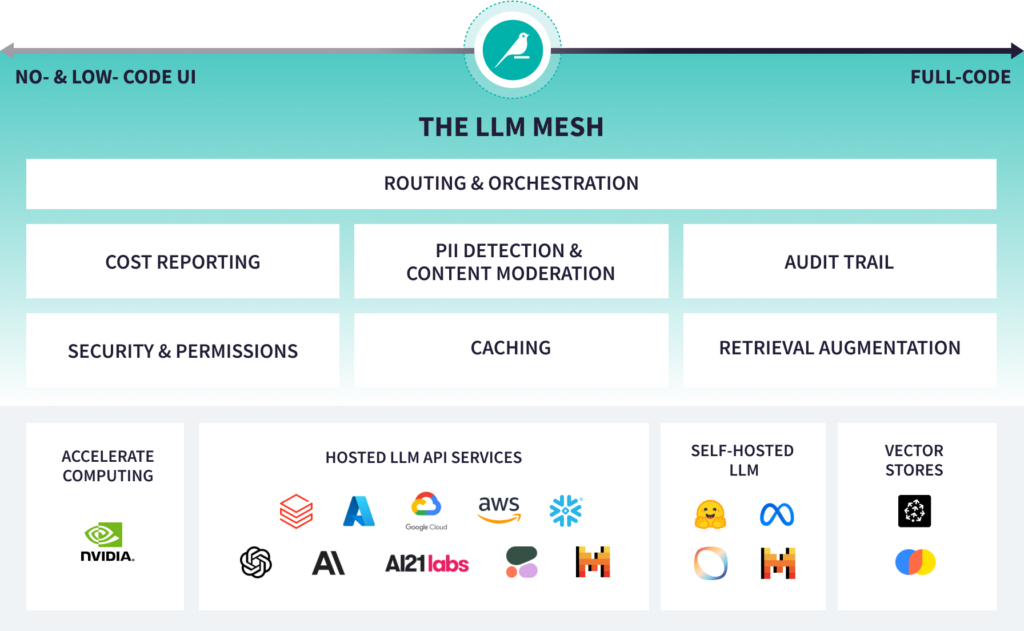

La gouvernance des données occupe une place centrale, dopée par les exigences réglementaires (RGPD, conformité sectorielle) et par la nécessité de garantir la sécurité et l’auditabilité des environnements. Dans cette logique, le data mesh et la fédération des données s’imposent comme des modèles de référence pour concilier autonomie locale et cohérence globale.

L’IA générative et l’analytique augmentée s’intègrent désormais directement aux plateformes, permettant aux équipes métiers de bénéficier de recommandations automatisées, d’insights en langage naturel et de capacités prédictives avancées. Enfin, la scalabilité data est repensée à l’ère de l’IA et du temps réel : plus qu’un critère technique, elle devient un levier stratégique pour transformer la donnée en valeur immédiate.

Pour aller plus loin ?

- Modern Data Platform for AI Era – Mubarack Ali (Medium) : https://medium.com/@mubarack.ali/modern-data-platform-for-ai-era-0815c916f6b1

- Gartner: 6 Data and Analytics Trends That Will Shape Future : https://www.linkedin.com/pulse/gartner-6-data-analytics-trends-shape-future-centida-jurff/

- Snowflake Key Concepts & Architecture : https://docs.snowflake.com/en/user-guide/intro-key-concepts

- Key Takeaways From The Forrester Wave™: Data Management For Analytics Platforms, Q2 2025 : https://www.forrester.com/blogs/key-takeaways-from-the-forrester-wave-dma-platforms-q2-2025/

- Back to the basics ! Zoom sur les différences entre un data warehouse dans le cloud, un data lake et data lakehouse : https://www.smartpoint.fr/back-to-the-basics-zoom-sur-les-differences-entre-un-data-warehouse-dans-le-cloud-un-data-lake-et-data-lakehouse/