Vous cherchez un outil d’intégration de données ? Smartpoint vous propose une rapide comparaison entre deux outils d’ETL qui ont actuellement le vent en poupe.

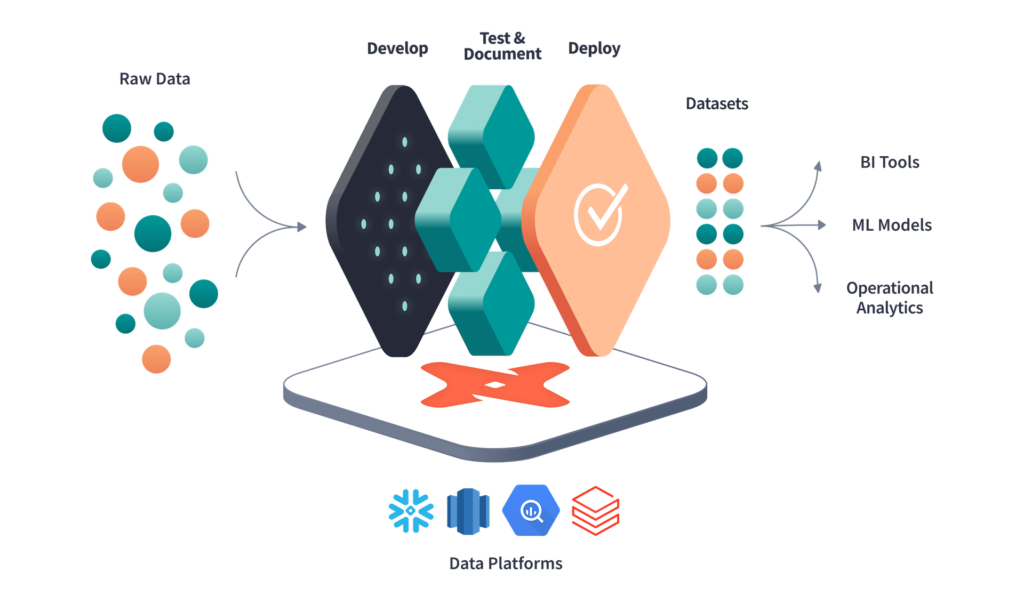

Les entreprises stockent leurs données dans différents endroits en interne mais aussi désormais de plus en plus dans le cloud. Pour disposer d’une vision unifiée de vos activités et être en capacité de les analyser, vous devez rassembler toutes ces data dans un entrepôt de données ou un data lake.

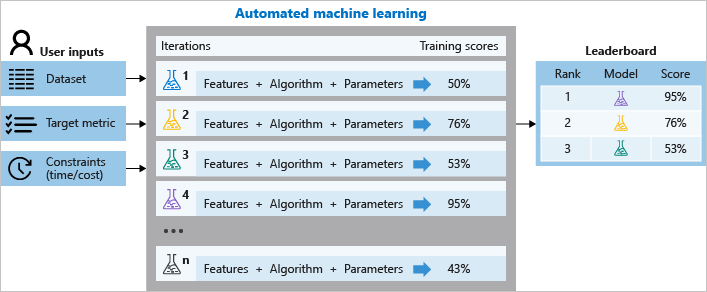

On utilise un ETL pour différents usages comme classiquement l’extraction, la transformation et le chargement dans des entrepôt de données. Ils sont aussi utilisés pour redresser la qualité des données afin qu’elles soient exploitables en data visualisation.

LEURS POINTS COMMUNS

Ils se connectent tous deux à de nombreuses sources de données (env 150 connecteurs pré-paramétrés chacun), ils sont RGPD et SOC 2 compliant. Les deux sont de purs ETL, ils ne transforment pas les données avant de les charger. Enfin, ils proposent tous deux un essai gratuit pendant 14 jours.

C’est un outil cloud destiné aux ingénieurs data et aux data analysts. Il est opérable avec tous les principaux entrepôts de données, bases de données… mais pas les data lakes. On peut difficilement personnaliser les connecteurs depuis le cloud … mais vous pouvez demander à l’éditeur de créer une nouvelle source de données. Cependant, vous ne pourrez pas le faire vous-même, ni modifier les sources existantes. Ainsi, si vous avez des besoins spécifiques, mieux vaut vous entourer d’un ingénieur data ! Fivetran ne transforme pas les données avant de les charger mais il permet désormais de faire à postériori via un copier-coller SQL.

C’est également un outil dans le cloud. Il fait désormais partie de Talend Data Fabric. En termes de destinations, via l’API Rest, il est capacité de déplacer les données dans tous les principaux entrepôts de données et bases de données mais aussi les data lakes. On peut rajouter de nouvelles sources en utilisant Singer (open source) pour réaliser des scripts mais ce n’est pas encore optimal en termes qualité, il faut tester ;-). Il ne permet pas non plus de transformer les données mais, via les outils proposés par Talend, il est possible de le faire soit au sein de l’entrepôt de données, soit via des moteurs de traitement externes tels que Spark et MapReduce. Les transformations peuvent être définies en SQL, Python ou Java.

Pour aller plus loin : https://www.techrepublic.com/article/stitch-vs-fivetran/ et https://airbyte.com/etl-tools/fivetran-vs-stitch