2023 a été très dense et rythmée notamment par les avancées technologiques spectaculaires de l’IA générative … mais pas que ! Exercice de début d’année oblige, Smartpoint, pure player data depuis 2006, vous dévoile ses prédictions pour 2024.

01

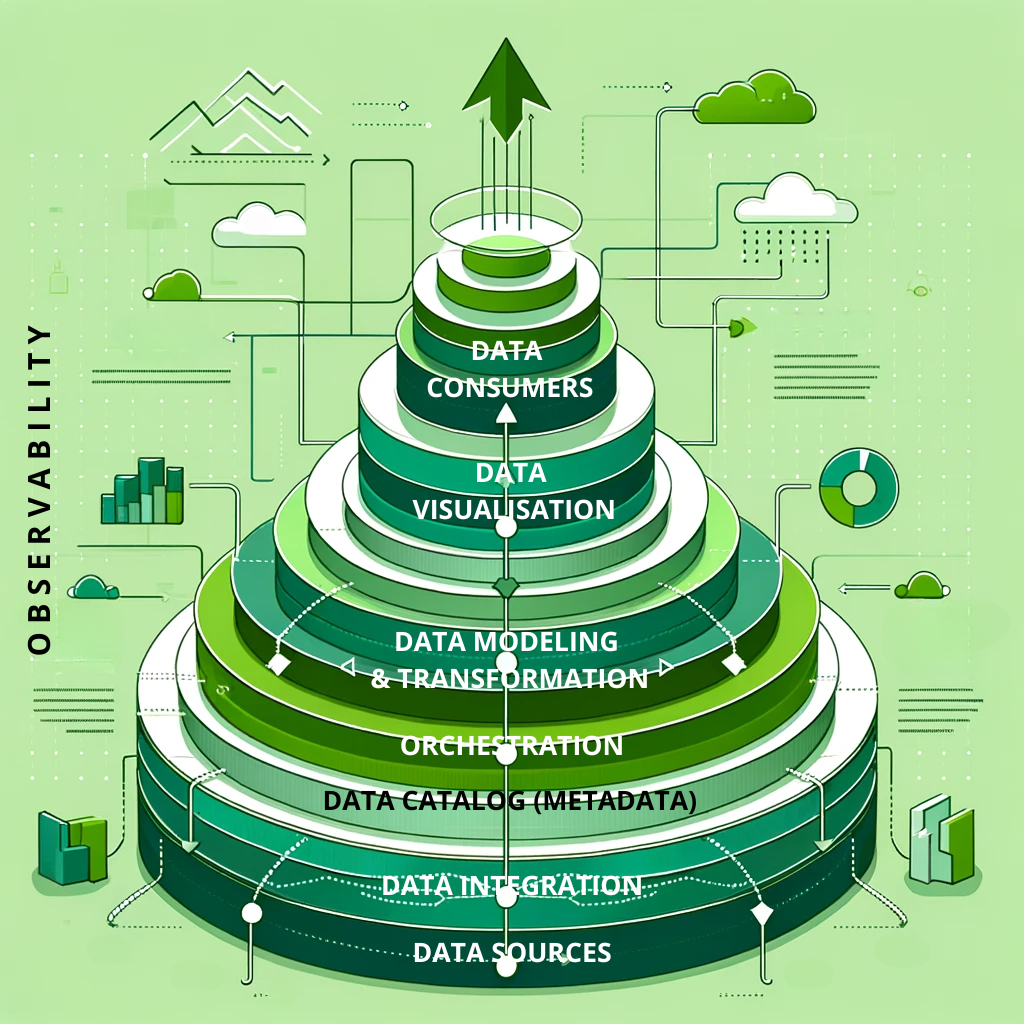

Un pipeline de données efficace, ce sera la base !

Il doit être en capacités d’ingérer de multiples sources de données de manière complètement transparente et sécurisée (IoT, fichiers, SQL, NoSQL, Web apps, etc.) puis de les intégrer (ETL/ELT).

Une alternative pour outiller votre pipeline en open source ? C’est à lire ici avec notre top 5 outils.

04

L’IA et le AutoML vont démocratiser l’analyse avancée des données.

L’adoption des grands modèles de langages (LLM) transforme l’interprétation des données sur de larges volumes et les rend compréhensibles pour le plus grand nombre. Ils ont d’ailleurs contribué à améliorer considérablement les performances du NLP.

Ils permettront de toujours mieux identifier des tendances, de mener des analyses plus fines et surtout plus pertinentes.

La conception et de le déploiement de modèles avancés de ML sont d’ailleurs devenus beaucoup plus accessibles (et rapides !) pour les ingénieurs data alors qu’ils étaient, jusqu’alors, réservés à des professionnels très expérimentés et spécialisés.

02

Une architecture Data Fabric et Data Mesh.

La Data Fabric fournit une vue unifiée avec un accès centralisé aux données et leur intégration dans un écosystème data distribué. Elle peut se connecter à des sources qui sont dans le cloud ou dans des environnements on-premise.

Le Data Mesh est une architecture décentralisée axée Domaine où les données sont traitées et gouvernées par des équipes qui en ont la responsabilité – comme un produit – permettant ainsi une infrastructure en libre service.

Leur adoption va permettre aux entreprises de gérer plus efficacement des écosystèmes toujours plus denses, et complexes ; de manière plus fluide, plus flexible et surtout plus évolutive dans la durée.

05

Une Data, plus durable et respectueuse de l’environnement.

La Data a elle aussi sa part de responsabilité à assumer et c’est possible (à lire ici).

Ainsi, on devrait voir enfin des considérations liées à l’empreinte carbone influer sur les choix des entreprises. La futur est dans des solutions plus sobres et vertueuses dès la phase de conception, au plus juste des usages attendus, moins gourmandes en termes d’échanges de données ou encore en consommation de ressources (traitement, calculs, stockage).

L’impact environnemental des systèmes data va progressivement s’appréhender sur l’ensemble de leur cycle des vie, de leur développement à leur décommisionnement.

Les critères ESG vont venir réguler les pratiques et c’est une bonne nouvelle pour l’ensemble de la profession.

03

Toujours plus d’automatisation des processus !

Ainsi, les tâches répétitives, chronophages et souvent sources d’erreurs sont prises en charge par des outils toujours plus intelligents notamment en nettoyage et intégration des données.

Il en est de même, grâce aux avancées en IA et en apprentissage automatique, pour le processus de data discovery et celui d’amélioration de la qualité des données (data quality) qui jusqu’alors demandaient beaucoup d’opérations manuelles.

06

Le data management et la gouvernance ne sont plus une option.

Avec l’essor de l’IA, est venu aussi le temps des questions d’éthique et de responsabilité, au-delà des simples contraintes règlementaires liées à la protection des données personnelles (RGPD).

L’UE a d’ailleurs obtenu un accord entre les états membres et le parlement européen début décembre 2023 sur une législation visant à règlementer l’IA et c’est une première mondiale ! (à lire ici ).

Ainsi, il ne sera plus possible à terme de collecter aveuglément des volumes de données sans en mesurer les risques, ni de les exploiter sans une transparence sur les traitements et les usages ; ainsi qu’un respect strict de la confidentialité et de la sécurité des données. Cette nouvelle loi devrait entrer en vigueur en 2026. On va voir ainsi apparaitre l’IA explicable, ou XAI, et cela va affecter l’exploitation des technologies d’IA.