Dernière mise à jour : octobre 2025

Alors que les volumes des données collectées croient de manière exponentielle dans une variété de formats considérable, vous devez choisir comment les stocker. Devez-vous opter pour un lac de données (datalake) ou pour un entrepôt de données (datawarehouse) ? Cette décision n’est pas anodine car elle influence l’architecture globale du système d’information data, la stratégie de gestion des données et, finalement, la capacité de votre entreprises à exploiter ces données pour créer de la valeur sur vos marchés.

Un datalake, c’est comme une vaste réserve centralisée conçue pour stocker de grandes quantités de données brutes, quel que soit le format. Son principal avantage réside dans sa capacité à héberger des données non structurées, semi-structurées et structurées, offrant ainsi une flexibilité sans précédent pour l’exploration, l’analyse et l’exploitation de données via des technologies avancées comme l’IA et le machine learning.

Un datawarehouse est une solution de stockage qui organise les données en schémas structurés et hiérarchisés. Spécialement conçu pour les requêtes et les analyses avancées, il est reconnu pour ses performances, sa fiabilité, l’intégrité des données pour les opérations décisionnelles et la génération de rapports.

Le choix entre ces deux architectures de stockage n’est pas anodin. Il doit être éclairé par une fine compréhension des besoins en données de votre entreprise, de ses objectifs stratégiques, de ses processus opérationnels et de ses capacités analytiques.

1. Comprendre les datalakes et les entrepôts de données

1.1 Définition et objectifs

Un datalake est une architecture de stockage conçue pour stocker de très larges volumes de données sous leur forme brute, c’est-à-dire dans leur format natif non transformé. Contrairement aux bases de données traditionnelles, il n’impose pas de schéma au moment de l’écriture des données (schema-on-write), mais au moment de la lecture (schema-on-read), offrant ainsi une souplesse inégalée dans la manipulation et l’exploration des données. L’objectif principal d’un datalake est de centraliser les données non structurées et structurées d’une entreprise pour permettre des analyses futures très diverses, y compris l’exploration de données, le big data, le datamining, les analytics et l’intelligence artificielle.

Un entrepôt de données, ou datawarehouse, est une solution de stockage qui collecte des données en provenance de différentes sources et les transforme selon un schéma fixe, structuré et prêt à l’emploi. Il est optimisé pour assurer la rapidité et l’efficacité des requêtes et des rapports analytiques. Il est conçu pour le traitement rapide des opérations de lecture et d’écriture. L’objectif d’un entrepôt de données est de fournir une vision cohérente et unifiée des données, facilitant ainsi la prise de décision et la génération de rapports standardisés pour les fonctions opérationnelles métiers et stratégiques de l’entreprise.

1.2 Comparaison des fonctionnalités et des cas d’utilisation

Fonctionnalités des datalakes

- Stockage de données à grande échelle en format brut

- Capacité de stockage économique qui permet de conserver des données hétérogènes, facilitant un large éventail d’analyses exploratoires et un réservoir à explorer d’innovations futures data centric

- Support de tous types de données (structurées, semi-structurées, non structurées) y compris des data tels que les logs, les flux IoT, etc.

- Écosystème propice à la démocratisation de l’analyse des données, permettant aux data scientists et aux analystes de travailler avec des données non préparées ou semi-préparées

- Flexibilité pour l’expérimentation avec des modèles de données évolutifs et des schémas à la volée

- Intégration facile avec des outils d’analyse avancée et de machine learning

- Flexibilité dans le modèle de données, qui permet des analyses exploratoires et ad-hoc

Fonctionnalités des datawarehouses

- Stockage de données organisé selon un schéma défini et optimisé pour les requêtes ; avec également des outils d’ETL (Extract, Transform, Load) éprouvés pour la transformation des données

- Haute performance pour les requêtes structurées et les rapports récurrents

- Une source de vérité unique pour l’entreprise, facilitant la cohérence et la standardisation des métriques et des KPIs

- Fiabilité et intégrité des données pour la prise de décision basée sur des données historiques consolidées

- Interfaces utilisateurs conviviales pour la business intelligence, avec des capacités de reporting avancées et des visualisations interactives.

- Intégration avec les systèmes de gestion de la relation client (CRM) et de planification des ressources de l’entreprise (ERP), enrichissant les données transactionnelles pour des analyses décisionnelles stratégiques

Cas d’utilisation des datalakes

- Scénarios nécessitant une exploration de données pour identifier des opportunités de marchés émergents, pour prévoir des tendances de consommation ou des modèles cachés.

- Environnements innovants où l’analytique en temps réel et l’intelligence opérationnelle peuvent transformer des flux de données en actions immédiates.

- Projets de recherche et développement (R&D) où des données variées doivent être explorées sans la contrainte d’un schéma prédéfini.

Cas d’utilisations des datawarehouses

- Dans les industries réglementées, comme les services financiers ou la santé, où l’intégrité et la traçabilité des données sont essentielles pour la conformité réglementaire.

- Lorsque l’on a besoin de mener des analyses sur de longues périodes pour suivre leur évolution au fil du temps et anticiper les tendances futures. Les data warehouses offre une base solide pour les systèmes décisionnels pour les managers qui souhaitent prendre leurs décisions sur la base de données historiques détaillées.

- Lorsqu’il est crucial de rapprocher des données issues de sources multiples en informations cohérentes pour piloter la stratégie d’entreprise et optimiser les processus opérationnels.

2. Avantages et Inconvénients

Avantages d’un data lake

Le data lake offre beaucoup de flexibilité pour le stockage de données. Son avantage principal réside dans sa capacité à accueillir tous types de données, des données structurées telles que les lignes et les colonnes des bases de données relationnelles, aux données non structurées comme les textes libres ou encore des médias. Ceci est un véritable avantage pour les organisations agiles qui souhaitent capitaliser sur la variété et la vitesse des données actuelles, y compris les données générées par les appareils connectés (IoT), les plateformes de médias sociaux, et autres sources numériques. L’intégration avec des plateformes d’analyses avancées et le machine learning permet d’extraire des insights précieux qui peuvent être sources d’innovation.

Avantages d’un Entrepôt de Données

L’entrepôt de données, quant à lui, est spécialement conçu pour la consolidation de données issues de divers systèmes en un format cohérent et uniforme. C’est un peu comme une bibliothèque traditionnelle où chaque livre – ou plutôt chaque donnée – a sa place attitrée, classée, indexée ! C’est une solution à privilégier pour les entreprises qui ont besoin d’effectuer des analyses complexes et récurrentes, qui exigent de la performance dans le traitement des requêtes. La structuration des données dans des schémas prédéfinis permet non seulement des interrogations rapides et précises mais assure également l’intégrité et la fiabilité des informations, ce qui est essentiel pour les rapports réglementaires, les audits et la prise de décision stratégique. Les Data warehouses sont également conçus pour interagir avec des outils de reporting et de business intelligence, offrant ainsi de la data visualisation et des analyses compréhensibles par les utilisateurs finaux.

Inconvénients, Limites et Défis

Malgré leurs nombreux avantages, les data lakes et les entrepôts de données ont chacun leurs limites ! Le data lake, de par sa nature même, peut devenir un « data swamp » si les données ne sont pas gérées et gouvernées correctement, rendant les informations difficilement exploitables. La mise en place d’une gouvernance efficace et d’un catalogue de données s’avère nécessaire pour maintenir la qualité et la questionnabilité des données.

Les data warehouses, bien que fortement structurés et performants pour les requêtes prédéfinies, peuvent être rigides en termes d’évolutivité et d’adaptabilité. L’intégration de nouvelles sources de données ou l’ajustement aux nouvelles exigences analytiques peut se révéler très coûteuse et chronophage. De plus, les entrepôts traditionnels peuvent ne pas être aussi bien adaptés à la manipulation de grands volumes de données non structurées, ce qui peut limiter leur application dans les scénarios où les formes de données sont en constante évolution.

3. Critères de choix entre un data lake et un data warehouse

3.1 Volume, Variété et Vitesse de la data

Les trois « V » de la gestion des données – volume, variété et vitesse – sont des critères essentiels dans votre choix entre un data lake et un data warehouse. Si votre organisation manipule des téraoctets ou même des pétaoctets de données diversifiées, issues de différentes sources en flux continus, un data lake est à priori le choix le plus adapté. Sa capacité à ingérer rapidement de grands volumes de données hétérogènes, voire évolutives, en fait un critère de choix déterminant dans les situations où la quantité et la multiplicité des données dictent la structure de l’infrastructure technologique.

3.2 Analyse et traitement des données

L’approche et les outils que vous utilisez pour l’analyse et le traitement des données influencent également le choix de votre architecture de stockage. Les data lakes, avec leur flexibilité et leur capacité d’ingestion de données en l’état, sont parfaitement adaptés aux environnements exploratoires où le data mining et le traitement par intelligence artificielle sont votre lot quotidien. En revanche, si vos besoins s’articulent autour d’analyses structurées et de reporting périodique, un data warehouse offre un environnement hautement performant optimisé pour ces activités, avec la possibilité d’extraire les données de manière rapide et fiable.

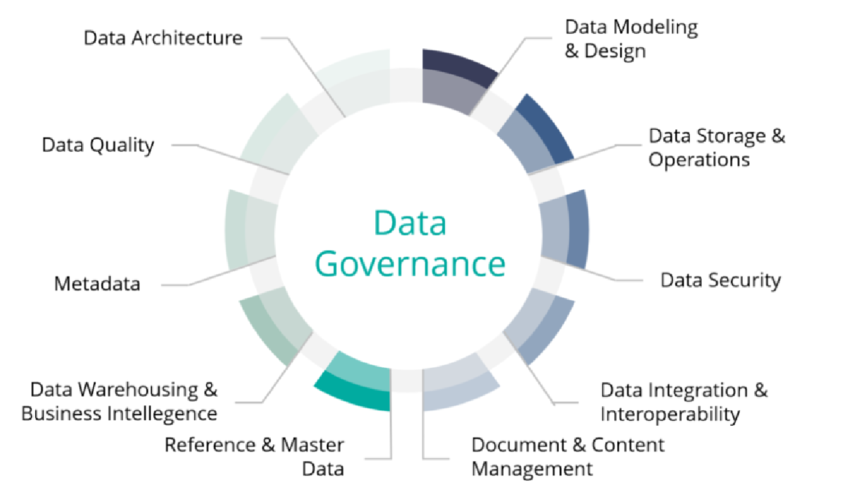

3.3 Gouvernance, sécurité et conformité

La manière dont vous gérez la gouvernance, la sécurité et la conformité des données est un facteur déterminant. Les data warehouses, avec leurs schémas de données structurés et leur maturité en matière de gestion de la qualité des données, offrent un cadre plus strict et sécurisé, ce qui est impératif dans les environnements réglementés. Les data lakes requièrent quant-à-eux une attention particulière en matière de gouvernance et de sécurité des données, surtout parce qu’ils stockent des informations à l’état brut, qui pourraient inclure des données sensibles ou personnelles.

3.4 Coûts et complexité de mise en oeuvre

Enfin, les considérations financières et la complexité de la mise en œuvre sont des critères déterminants. Mettre en place un data lake est souvent moins coûteux en termes de stockage brut, mais nécessite souvent des investissements significatifs additifs en outils et en compétences pour être en capacités d’exploiter pleinement cet environnement. Les data warehouses, en revanche, générèrent souvent des coûts initiaux plus élevés, mais leur utilisation est souvent plus rapide et moins complexe, avec un ensemble d’outils déjà intégrés pour la gestion et l’analyse des données.

4. Architecture et technologies : Data Lakes vs. Data Warehouses

L’architecture et les technologies des data lakes et des data warehouses révèlent des différences essentielles dans la manière dont les données sont stockées, gérées, et exploitées. Ces différences influencent directement le choix entre ces deux solutions en fonction des besoins spécifiques en matière de données.

4.1. Stockage de Données

- Data Lakes : Les data lakes sont conçus pour stocker d’énormes volumes de données sous leur forme brute, sans nécessiter de schéma prédéfini pour le stockage. Cela permet une grande flexibilité dans le type de données stockées, qu’elles soient structurées, semi-structurées ou non structurées. Les technologies comme Apache Hadoop et les services cloud comme Amazon S3 sont souvent utilisés en raison leur évolutivité et leurs capacités à gérer de très larges volumes.

- Data Warehouses : À l’inverse, les data warehouses stockent des données qui ont été préalablement traitées (ETL – Extract, transform & load) et structurées selon un schéma prédéfini, ce qui facilite les requêtes complexes et l’analyse de données. Des solutions comme Amazon Redshift, Google BigQuery, et Snowflake sont reconnues pour leur efficacité dans le stockage et la gestion de données structurées à grande échelle.

4.2. Indexation et Optimisation des Requêtes

- Data Lakes : L’indexation dans les data lakes peut être plus complexe en raison de de l’hétérogénéité des formats de données. Cependant, des outils comme Apache Lucene ou Elasticsearch peuvent être intégrés pour améliorer la recherche et l’analyse des données non structurées. Les data lakes requièrent souvent un traitement supplémentaire pour optimiser les requêtes.

- Data Warehouses : Les data warehouses bénéficient d’une indexation et d’une optimisation des requêtes plus avancées dès le départ, grâce à leur structure hautement organisée. Des techniques comme le partitionnement des données et le stockage en colonnes (par exemple, dans Amazon Redshift) permettent d’exécuter des analyses complexes et des requêtes à haute performance de manière plus efficace.

4.3. Technologies et outils éditeurs

Différents éditeurs et technologies offrent des solutions spécialisées pour les data lakes et les data warehouse :

Pour les Data Lakes :

- Apache Hadoop : Écosystème open-source qui permet le stockage et le traitement de grandes quantités de données.

- Amazon S3 : Service de stockage objet offrant une scalabilité, une disponibilité et une sécurité des données.

- Microsoft Azure Data Lake Storage : Solution de stockage haute performance pour les data lakes sur Azure.

Pour les Data Warehouses

- Snowflake : Infrastructure de données cloud offrant une séparation du stockage et du calcul pour une élasticité et une performance optimisée.

- Google BigQuery : Entrepôt de données serverless, hautement scalable, et basé sur le cloud.

- Oracle Exadata : Solution conçue pour offrir performance et fiabilité pour les applications de bases de données critiques.

Databricks, le pont entre Data Lakes et Data Warehouses

Databricks a un rôle crucial dans l’évolution des architectures de données en offrant une solution qui réduit la frontière entre les data lakes et les data warehouses. Par son approche lakehouse, Databricks permet aux organisations de gérer leurs données de manière plus efficace, en facilitant à la fois le stockage de grandes quantités de données brutes et l’analyse avancée de ces données.

- Plateforme Unifiée : Databricks offre une plateforme basée sur Apache Spark qui permet aux utilisateurs de réaliser des tâches d’ingénierie de données, de science des données, de machine learning, et d’analyse de données sur un même environnement. Cette approche intégrée facilite la collaboration entre les équipes et optimise le traitement des données.

- Data Lakehouse : Databricks promeut le concept de « Lakehouse », un modèle d’architecture qui combine les avantages des data lakes et des data warehouses. Le lakehouse vise à fournir la flexibilité et la capacité de stockage des data lakes pour des données brutes et diversifiées, tout en offrant les capacités d’analyse et de gestion de la qualité des données typiques des data warehouses.

- Delta Lake : La technologie proposée par Databricks est Delta Lake, un format de stockage qui apporte des fonctionnalités transactionnelles, de gestion de la qualité des données, et d’optimisation des requêtes aux data lakes. Delta Lake permet aux organisations de construire un data lakehouse, en rendant les data lakes plus fiables et performants pour des analyses complexes.

- Avantages en architectures Data : En utilisant Databricks, les entreprises peuvent tirer parti de la scalabilité et de la flexibilité des data lakes tout en bénéficiant des performances et de la fiabilité des data warehouses. Cette approche permet d’effectuer des analyses avancées, du traitement de données en temps réel, et du machine learning à grande échelle.

- Intégration avec les Écosystèmes de Données Existantes : Databricks s’intègre facilement avec d’autres plateformes de données, comme les services de stockage cloud (Amazon S3, Azure Data Lake Storage, Google Cloud Storage) et les solutions de data warehouse (Snowflake, Google BigQuery, etc.), offrant ainsi une grande flexibilité dans la conception de l’architecture de données.

5. Cas pratiques et scénarios d’utilisation par secteur

5.1 Cas d’utilisation d’un Data Lake

- Géants du web : Les entreprises de la tech utilisent des data lakes pour analyser d’importants volumes de données utilisateurs afin d’affiner les algorithmes de recommandation, de personnaliser l’expérience client et d’optimiser les stratégies de contenu et de publicité.

- Industries : Les data lakes permettent de collecter et d’analyser les données issues des capteurs IoT pour la surveillance en temps réel des équipements, l’optimisation des chaînes logistiques, et la prévision des opérations de maintenance.

- Transport : Les entreprises du secteur automobile exploitent des data lakes pour traiter de grandes quantités de données issues de tests de véhicules et ou encore celles relatives aux véhicules autonomes et à l’analyse des comportements de conduite.

5.2 Cas d’utilisation d’un Entrepôt de Données

- Finance et banque : Les institutions financières et bancaires s’appuient sur des data warehouses pour effectuer des analyses de marché, générer des rapports de performance financière, et conduire des analyses de risques basées sur des données historiques.

- Retail : Les entreprises de retail utilisent des data warehouses pour analyser les tendances d’achat et de consommation sur plusieurs années, permettant une gestion des stocks plus précise et le développement de campagnes marketing ciblées.

- Énergie : Les sociétés du secteur de l’énergie exploitent des data warehouses pour la gestion des données relatives à la production, à la consommation énergétique, et pour se conformer aux régulations environnementales et leur exigences en termes de reporting.

5.3 Synthèse des meilleures pratiques

Une mise en œuvre réussie des data lakes et des data warehouses dépend de la stratégie qui va orienter votre choix d’architecture de données.

Pour les Data Lakes

- Gouvernance rigoureuse : Instaurez un cadre strict de gouvernance pour maintenir l’intégrité des données et clarifier l’accès et l’utilisation des données.

- Qualité : Intégrez des processus systématiques pour le nettoyage et la validation des données, garantissant leur fiabilité pour l’analyse et la prise de décision dans la durée.

- Catalogage : Adoptez des solutions de Data Catalog pour faciliter la recherche et l’utilisation des données stockées, transformant le data lake en un réservoir de connaissances exploitables.

Pour les Data Warehouses

- Maintenance proactive : Menez des audits réguliers pour préserver les performances et adapter la structure aux besoins évolutifs de l’entreprise.

- Évolution : Faites évoluer votre écosystème data avec prudence, en intégrant des innovations technologiques pour améliorer les capacités analytiques et opérationnelles.

- Compétences à: Investissez dans la formation des équipes pour qu’elles restent à la pointe de la technologie et puissent tirer le meilleur parti de l’infrastructure de données.

Le débat entre data lake et data warehouse ne se réduit pas à un simple choix technologique ; il s’agit d’une décision stratégique qui reflète la vision, la culture et les objectifs de votre entreprise en matière de création de valeur à partir de l’exploitation des données. Alors qu’un data lake offre une palette vaste et flexible pour l’agrégation de données brutes propices à l’exploration et à l’innovation analytique ; un data warehouse apporte une structure organisée et performante pour le reporting et les analyses décisionnelles.

Votre choix dépend en somme des objectifs spécifiques de votre entreprise, des exigences en matière de gouvernance des données, de la variété et du volume des données, ainsi que de la rapidité avec laquelle l’information doit être convertie en action. Le data lake convient aux organisations qui aspirent à une exploration de données libre et sans contrainte, où les potentiels de l’IA et du machine learning peuvent être pleinement exploités. Inversement, le data warehouse est la solution pour ceux qui cherchent à solidifier leur Business Intelligence avec des données cohérentes et fiables.

Les data lakes et data warehouses ne sont pas mutuellement exclusifs et peuvent tout à fait coexister, se complétant mutuellement au sein d’une architecture de données bien conçue, permettant ainsi aux organisations de tirer le meilleur parti des deux mondes.