Adopter une infrastructure data moderne est devenu un incontournable pour les entreprises souhaitant tirer parti de l’IA générative et des LLMs (Large Language Models). En effet, avec des besoins croissants en termes de scalabilité, de gouvernance et de sécurité, les CIO et les chief data officer tendent vers une approche cloud-native et plus agile pour moderniser l’architecture data. Parlons de LLM Mesh et architecture data IA.

Estimated reading time: 8 minutes

Qu’est-ce que le LLM Mesh ?

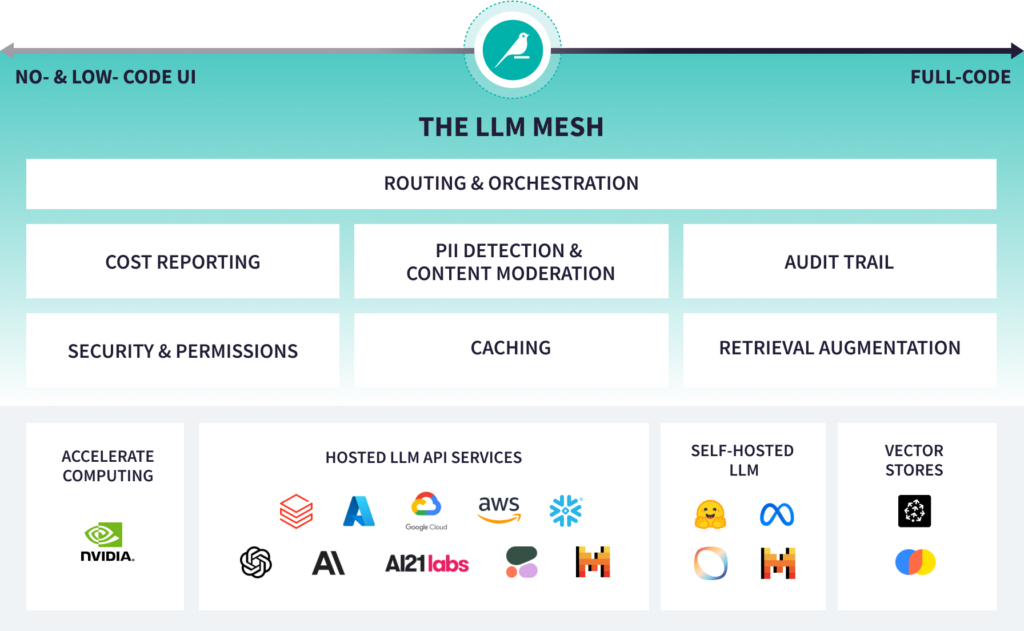

Le LLM Mesh est une couche d’orchestration au sein de l’architecture data conçue pour intégrer et exploiter des modèles de langage à grande échelle (LLMs) dans les environnements d’entreprise.

Le rôle et le fonctionnement du LLM Mesh

le LLM Mesh fonctionne comme un centre de contrôle, c’est à dire, il permet :

- L’intégration agnostique de multiples LLMs (OpenAI, Mistral, Claude d’Anthropic …) via des connecteurs API unifiés, tout en préservant la flexibilité dans le choix du modèle le plus adapté (coût, performance, langue, souveraineté).

- L’orchestration des flux de données entre les modèles et les systèmes data de l’entreprise (data warehouse, data lakehouse, data mesh, grâce à une architecture cloud-native qui rend possible le déploiement hybride et multi-cloud.

- La gouvernance et la sécurité des modèles via une couche de monitoring et de contrôle qualité intégrée (politiques de confidentialité, chiffrement des flux, audit des requêtes, logs).

- L’optimisation dynamique des performances en monitorant les coûts d’inférence, les latences et les métriques métiers afin de réallouer les ressources de manière intelligente.

Pourquoi choisir un LLM Mesh pour votre architecture Data / IA?

Le LLM Mesh dans une architecture data IA répond aux besoins d’évolutivité et de résilience des architectures data cloud-native, telles que Snowflake, BigQuery, Azure ou AWS. Via sa conception même, il s’intègre aux architectures data lakehouse, data mesh et data fabric, permettant une interopérabilité totale avec les pipelines data existants, qu’il s’agisse d’ETL, d’API ou de microservices. Il permet également de centraliser la gouvernance des données et des modèles (authentification, autorisations, conformité réglementaire), tout en restant ouvert et flexible pour accueillir les innovations portées par l’IA.

Le LLM Mesh facilite l’industrialisation des cas d’usage IA à grande échelle, comme les agents conversationnels, les copilotes métiers, la classification automatique, l’analyse sémantique ou encore la génération de texte. Véritable colonne vertébrale de votre architecture data, il transforme l’environnement existant en un socle scalable, sécurisé et prêt à accueillir l’IA générative de manière industrielle et fiable.

Quels sont les avantages du LLM Mesh pour votre architecture Data ?

- Modernisation de l’architecture data : le LLM Mesh permet une adoption plus simple des dernières technologies IA, tout en préservant l’existant et en favorisant l’agilité.

- Architecture data cloud-native : intégration fluide avec les plateformes cloud comme Snowflake, BigQuery, Azure ou AWS, permettant une scalabilité et une élasticité sans précédent.

- Interopérabilité des modèles : gestion unifiée des LLMs grâce à une architecture data mesh ou data lakehouse qui simplifie la gouvernance et la traçabilité des flux de données.

Quelles meilleures pratiques pour le LLM Mesh architecture data IA ?

Pour construire une architecture data scalable, il est recommandé d’adopter un LLM Mesh. Celui-ci permet d’orchestrer les modèles IA à grande échelle tout en optimisant les coûts et les performances (latence, ressources, monitoring). Grâce à une gestion centralisée, le LLM Mesh facilite l’intégration et l’évolution des modèles IA dans une architecture data moderne et cloud-native.

Le data mesh repose sur une approche décentralisée des données avec des domaines métiers responsables de la gouvernance et de la qualité. Le data lakehouse, quant à lui, combine les avantages des entrepôts de données et des data lakes pour une architecture unifiée. Le LLM Mesh s’intègre naturellement à ces deux approches, offrant une gouvernance centralisée des modèles IA et une flexibilité optimale pour répondre aux besoins métier et IT.

Oui, un excellent exemple est la solution proposée par Dataiku, qui intègre un LLM Mesh avec Snowflake Cortex AI. Cette intégration illustre parfaitement une architecture data moderne, cloud-native et prête pour l’industrialisation des projets d’IA générative à grande échelle.

Pour moderniser son architecture data, il est recommandé de privilégier des solutions qui allient gouvernance, sécurité et interopérabilité. Ces trois fondamentaux permettent d’éviter les dépendances technologiques et de garantir la pérennité des investissements data, tout en restant agile face aux innovations IA et aux évolutions technologiques.

Les dernières annonces Dataiku : un pas de plus vers l’industrialisation des LLM Mesh

En juin 2025, Dataiku a consolidé son positionnement de leader en figurant pour la quatrième fois consécutive dans le Gartner® Magic Quadrant™ for Data Science and Machine Learning Platforms.

L’un des axes majeurs de cette reconnaissance est la mise en avant du LLM Mesh, que Dataiku positionne comme LA base pour orchestrer les modèles de langage à grande échelle (LLMs) dans une architecture data moderne. Cette approche repose sur une gouvernance centralisée, une intégration cloud-native et une interopérabilité avec les principales plateformes data.

Par ailleurs, Dataiku a annoncé l’intégration du LLM Mesh avec Snowflake Cortex AI permettant de construire des agents IA via un environnement no-code, d’exploiter les fonctionnalités avancées de Snowflake (Cortex LLMs, Cortex Search, Cortex Analyst) et de garantir la sécurité et la gouvernance des données tout au long du cycle de vie des modèles IA.

Cette intégration montre en effet l’importance croissante des infrastructures data hybrides et cloud-native où le LLM Mesh joue un rôle central pour accompagner les DSI et les Responsables Data dans leurs stratégies IA.

Comparatif des solutions « LLM Mesh »

Face au développement des LLMs, plusieurs acteurs du marché proposent des solutions pour orchestrer et gouverner ces modèles à grande échelle. Dataiku utilise le terme « LLM Mesh » pour désigner sa couche d’orchestration mais d’autres plateformes data intègrent des fonctionnalités proches ou équivalentes : orchestration des flux de données, gouvernance centralisée, supervision des coûts et intégration cloud-native.

| Critères / Acteurs | Dataiku (LLM Mesh) | Snowflake Cortex AI | Databricks (MosaicML) | AWS Bedrock | IBM watsonx.ai | Microsoft Azure ML + Prompt Flow |

| Positionnement | Agnostique, plateforme data IA, orchestration et gouvernance des LLMs | Plateforme cloud-native Snowflake, intégration IA native | Lakehouse IA, orchestration et entraînement des LLMs | Cadre pour orchestrer et gouverner des LLMs multi-fournisseurs | Plateforme IA gouvernée, data fabric et data mesh | Orchestration LLMs, intégration aux pipelines IA |

| Gouvernance centralisée | Authentification, autorisations, supervision | Gouvernance native Snowflake | Gouvernance davantage intégrée au Lakehouse | Contrôles via services managés AWS | Gouvernance intégrée | Sécurité et gouvernance Azure (RBAC) |

| Intégration cloud-native | Multi-cloud et Snowflake | Snowflake uniquement | Multi-cloud (Azure, AWS, GCP) | AWS uniquement | IBM Cloud (extension possible multi-cloud) | Azure et partiellement multi-cloud |

| Flexibilité / agnosticité | Multi-LLM et agnostique | Spécifique à Snowflake | Plus orienté Databricks et MosaicML | Fournisseurs IA sélectionnés (Anthropic, AI21) | Large choix de modèles IA intégrés | Compatible Azure OpenAI, Hugging Face |

| Supervision des coûts et performance | Monitoring et allocation intelligente des ressources | Coût intégré au modèle Snowflake | Monitoring Lakehouse et MosaicML | Coûts gérés via AWS services | Monitoring watsonx.governance | Monitoring Azure (ML Monitoring) |

| Interopérabilité avec data mesh / lakehouse | Data mesh, data lakehouse et Snowflake | Snowflake data warehouse | Lakehouse natif | Intégration plus complexe, souvent manuelle | Intégration avec data fabric et data mesh | Compatible Data Factory et Synapse |

| Offre no-code / low-code | Interface Dataiku Visual Recipes | Intégration no-code avec Cortex AI | Plus orienté notebooks et code | Moins développé, plutôt API-based | Interface no-code et notebooks | Azure ML Designer et Prompt Flow (no-code) |

En résumé

Pour conclure, en 2025, , l’adoption d’un LLM Mesh est une tendance de fond pour bâtir une infrastructure data moderne résiliente et évolutive. Cette approche permet aux DSI et Responsables Data d’intégrer les meilleurs modèles IA tout en préservant la gouvernance des données et en favorisant la scalabilité.

Architecture Data IA, modernisation plateforme data, gouvernance des données, analytics avancés ou renfort projet : que vous cherchiez un partenaire conseil ou des experts opérationnels,

Smartpoint vous accompagne, en mission comme en expertise.

Les champs obligatoires sont indiqués avec *.