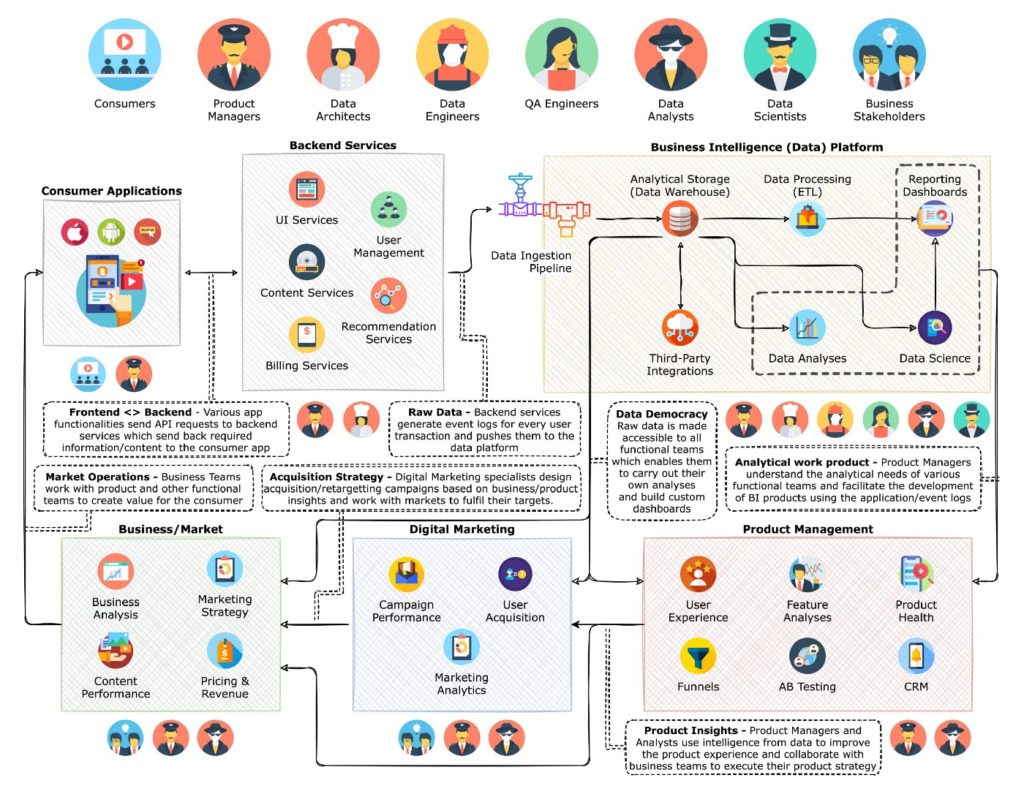

Le nouvel ensemble propose désormais deux pôles d’expertises majeurs en Data et Développement de produits.

Paris, le 10 juin 2022

Smartpoint, pure player de la Data, annonce le rapprochement avec Captiva, ESN parisienne de près de 80 collaborateurs, spécialisée dans le développement de produits et la qualité logicielle.

Désormais, le groupe Smartpoint, c’est une proposition de valeur élargie en expertises technologiques autour des deux principaux chantiers des entreprises en France pour soutenir leur transformation digitale : l’exploitation de la data et sa valorisation ; ainsi que le développement de nouveaux produits.

Le nouvel ensemble compte plus 250 collaborateurs qui réalisent des prestations IT ou délivrent des projets au forfait pour des entreprises des secteurs de la banque-assurance, la grande distribution, le transport, l’énergie, les média et les services.

Conformément à notre plan de croissance, nous cherchions à nous développer en nous rapprochant d’entreprises qui nous ressemblent en termes de valeurs et de vision. C’est chose faite avec Captiva et ses 80 collaborateurs, qui rejoignent l’aventure et vont désormais partager nos ambitions. Captiva est spécialisée en développement applicatif, testing et AMOA. En termes de références clients, pour ne citer que quelques comptes, Captiva intervient aujourd’hui au sein du Groupe Crédit Agricole, Accor Hotels et Manpower. Nous sommes donc très complémentaires et ce rapprochement va nous permettre d’avoir une position plus forte sur notre marché.

Yazid Nechi, Président de Smartpoint